Quand je parcours les thèmes de mon IDE et que je tombe sur un thème clair

Quand je montre une solution de contournement au commercial pour qu'il esquive un bug pendant sa démo

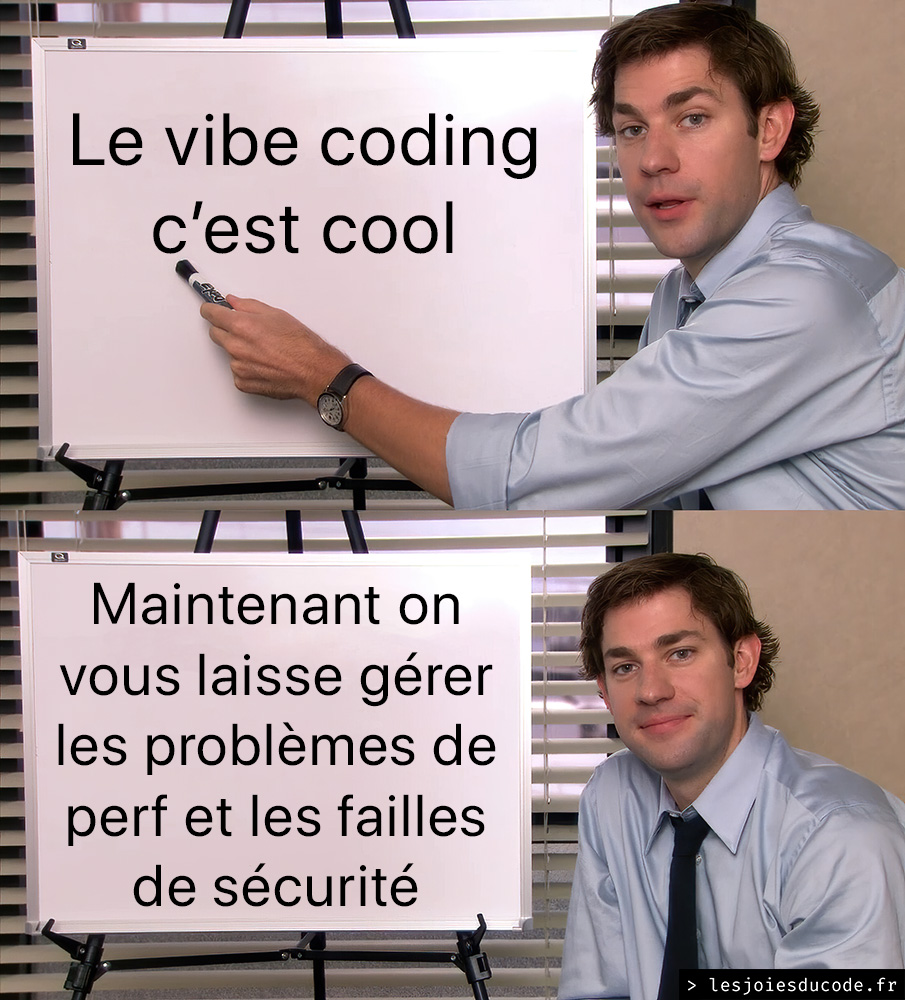

Vive le vibe coding carrément

Meta soupçonné d'avoir triché pour faire briller son nouveau modèle Llama 4 dans les benchmarks d'IA

La main dans le sac ? — Le lancement de la famille de nouveaux modèles IA Llama 4 par Meta ce week-end n'a pas manqué de faire du bruit dans les sphères tech.

Présentés comme des poids lourds de l'intelligence artificielle, les modèles Scout et Maverick de la famille Llama 4 ont été annoncés comme les premiers à intégrer l’approche Mixture of Experts (MoE) — une technique d'architecture qui permet d’augmenter la puissance d’un modèle tout en limitant les ressources utilisées à chaque requête.

Mais au-delà des performances techniques affichées, une controverse a rapidement éclaté : Meta aurait soumis une version non publique de Llama 4 sur la plateforme de benchmark LMArena, afin de maximiser son score et sa position au classement.