GPT-4 est dans la place — Sa sortie imminente avait été annoncée la semaine dernière, c'est désormais chose faite : OpenAI vient de sortir GPT-4, la nouvelle version de son modèle d'intelligence artificielle révolutionnaire, qui alimente ChatGPT.

GPT-4 est un large modèle multimodal, capable d'accepter les entrées texte mais aussi — et c'est une nouveauté — les images. Ses sorties restent quant à elles exclusivement au format texte.

Dévoilé hier soir, GPT-4 est déjà disponible pour les utilisateurs payants du service ChatGPT Plus d'OpenAI (avec une limite d'utilisation), et les développeurs peuvent d'ores et déjà s'inscrire à la liste d'attente pour accéder à son API.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

Sa tarification est de l'ordre de 0,03 dollar pour 1000 tokens de saisie (le texte avec lequel vous alimentez l'IA pour qu'elle traite votre demande) et de 0,06 dollar pour 1000 tokens de génération (le texte généré par l'IA). Les tokens correspondent à de courts ensembles de texte brut, et couvrent environ 750 mots.

Fait surprenant : GPT-4 était en réalité déjà dans la nature depuis plusieurs semaines, au nez et à la barbe des utilisateurs de Bing Chat !

Microsoft, qui dispose comme on le sait d'un partenariat renforcé avec OpenAI depuis ce début d'année, a en effet confirmé que la nouvelle version de GPT était intégrée dans le chatbot de son moteur de recherche depuis plus d'un mois.

Un modèle plus performant

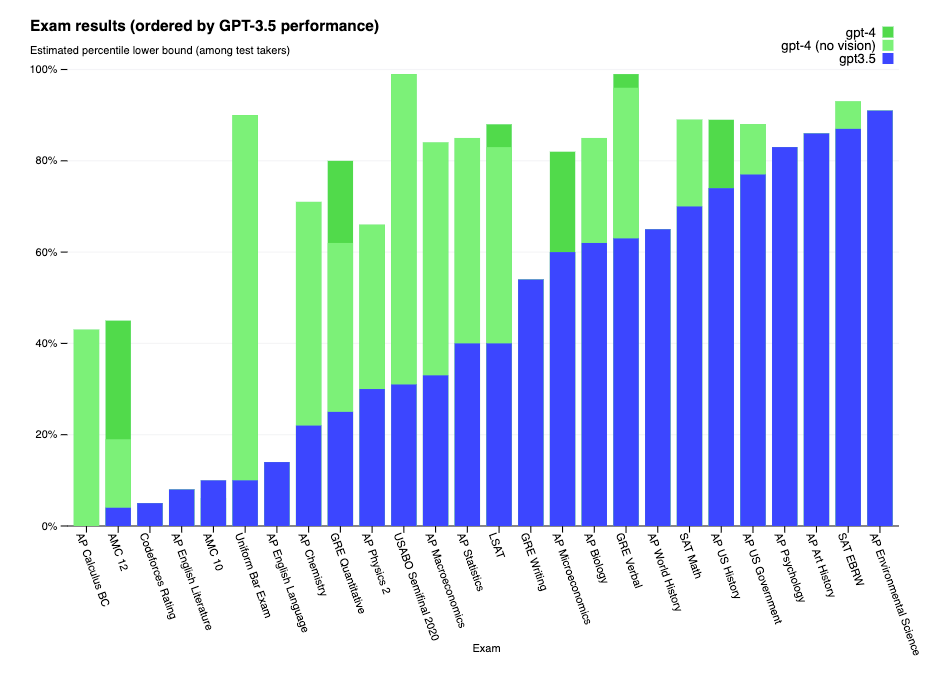

Preuve de la forte amélioration (attendue) du modèle : GPT-4 serait en mesure de générer des réponses plus "humaines", et performe beaucoup mieux face à des évaluations professionnelles et académiques.

L'intelligence artificielle a notamment été confrontée à une simulation de l'examen du barreau (ordre des avocats) et est parvenue à se classer dans le top 10% des participants, là où sa version précédente, GPT-3.5 se classait plutôt dans les 10% en bas du classement.

OpenAI a travaillé avec Microsoft pour développer un superordinateur dans le cloud Azure, qui fut utilisé pour entraîner GPT-4.

La laboratoire aurait par la même occasion enchaîné 6 mois d'itération pour "aligner" GPT-4, en s'appuyant sur plusieurs programmes de tests mais aussi sur les réponses formulées par ChatGPT.

Grâce à ces améliorations continues, l'IA générerait des réponses plus fiables et factuelles (même si cela reste encore perfectible), et disposerait d'une meilleure capacité d'adaptation dans ses échanges. Selon OpenAI, elle serait également plus créative et capable de gérer plus de nuances dans les instructions que GPT-3.5.

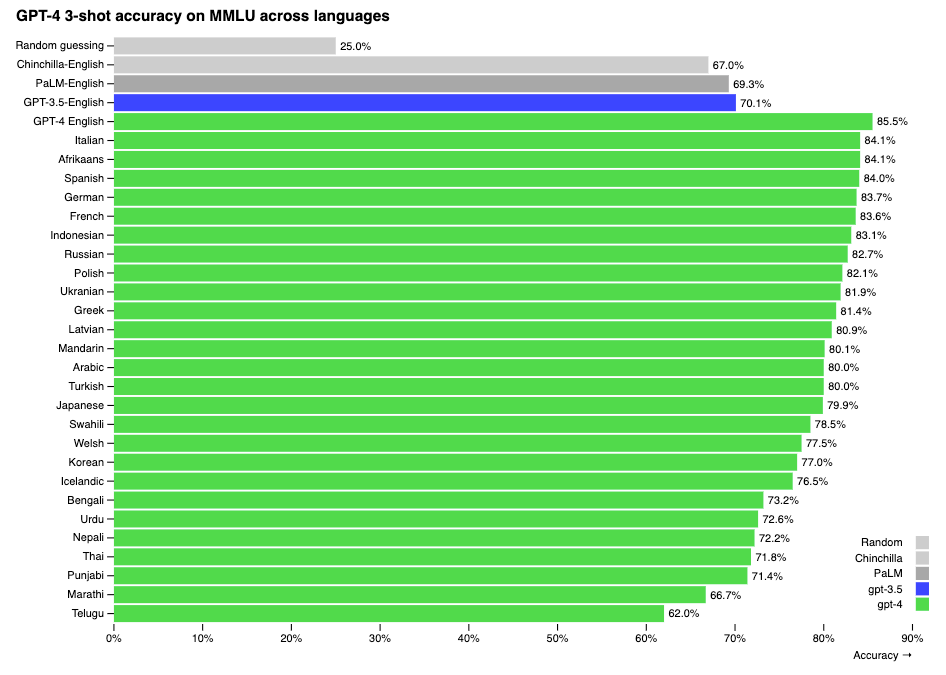

GPT-4 dépasse de loin son prédécesseur en terme de compréhension de la langue anglaise, et le Français dispose également de très bons résultats de prise en compte pour cette nouvelle version.

De même, le modèle serait équipé de meilleurs garde-fous, qui devraient lui empêcher d'être amené sur des terrains sensibles hors de son cadre d'application, là où certaines conversations était parvenues à l'amener ces derniers mois (et à le faire complètement délirer, voire tomber en dépression).

Comme pour les autres versions des modèles GPT, GPT-4 a été entraîné sur des données publiques, parmi lesquelles des pages web publiques, ainsi que des jeux de données sous licence chez OpenAI.

Une compréhension des images

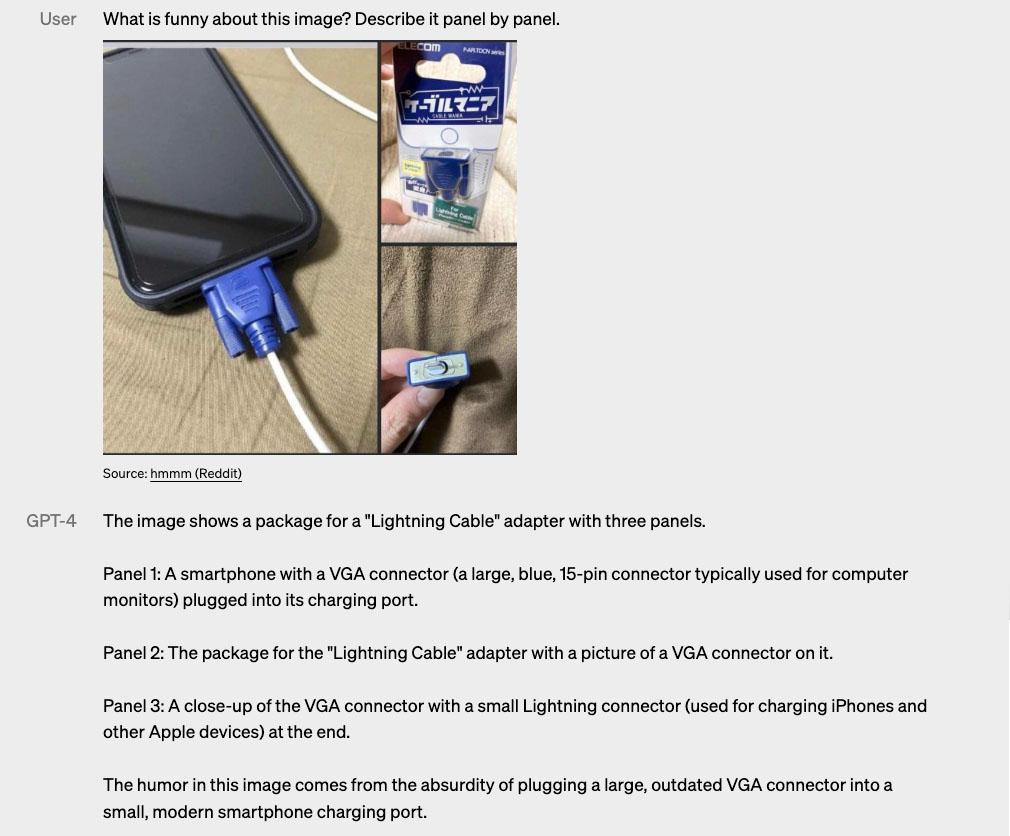

La grande nouveauté chez GPT-4, c'est sa capacité à prendre en compte des images en entrée (ce qui fait de lui ce qu'on appelle un modèle multimodal) : l'IA serait en mesure de comprendre les images tout aussi bien que le texte.

GPT-4 peut décrire, voire même interpréter, des images relativement complexes : OpenAI fournit un exemple sur son site avec l'image d'un câble Lightning pour iPhone en forme de connecteur VGA.

La prise en compte des images n'est pas encore disponible pour tous les clients d'OpenAI.

Pour le moment, le laboratoire teste cette fonctionnalité avec un unique partenaire : l'application mobile danoise Be My Eyes, qui permet de venir en aide aux personnes aveugles ou malvoyantes en leur fournissant une assistance visuelle pour par exemple distinguer les couleurs des vêtements, vérifier si les lumières sont allumées ou préparer un repas.

C'est GPT-4 qui alimente le nouvel assistant virtuel de cette application, et qui, en plus de pouvoir identifier avec précision les aliments présents dans un réfrigérateur, est également capable d'extrapoler en proposant des recettes réalisables avec les ingrédients disponibles, et de guider l'utilisateur à travers les différentes étapes de préparation.

Des intégrations à venir

Parmi les améliorations de GPT-4, on trouve également la possibilité pour les développeurs (et bientôt les utilisateurs de ChatGPT) de configurer sa tonalité et de définir des limites pour ses interactions, par le biais de "messages systèmes".

Alors qu'on attendait une présentation de GPT-4 à l'occasion d'un événement Microsoft sur le futur du travail ce jeudi, il semble que les deux entreprises partenaires soit plutôt en train de mener une communication en deux temps.

Microsoft n'a pas caché ses ambitions sur l'intégration du modèle d'intelligence artificielle dans ses services. Il y a fort à parier que cette conférence, à laquelle prendra part le CEO Satya Nadella, soit l'occasion de découvrir de nouvelles fonctionnalités en lien avec GPT-4 dans les produits de la firme, dont sa suite bureautique Office 365.

À lire aussi sur Les Joies du Code :

- 📚 Lecture : The Pragmatic Programmer, un classique pour la bibliothèque des développeurs ?

- 🛠️ Les API de ChatGPT et Whisper sont désormais disponibles pour les développeurs

- 🥊 Google dévoile Bard, son IA conversationnelle pour contrer ChatGPT