La conférence dotAI 2024, exclusivement dédiée à l’intelligence artificielle, s’est tenue les 17 et 18 octobre derniers.

Comme vous le savez déjà, j’ai eu la chance d’y participer ! Il est maintenant temps pour moi de vous dresser ici un petit récap de l’état des lieux de l’IA générative et des annonces qui ont rythmé cet événement consacré à l’IA avec un grand I et un grand A.

# En partenariat avec dotConferences

Les LLM ont atteint une limite mais les opportunités se multiplient

C’est un élément sur lequel de nombreux intervenants se sont accordés au cours de dotAI : les LLM tels que nous les connaissons aujourd’hui semblent avoir atteint un plafond en termes de performances, une situation qui pourrait bien perdurer dans les années à venir.

Néanmoins, comme l’a affirmé Stanislas Polu, ancien chercheur chez OpenAI et actuel cofondateur d’une startup dédiée à la création d’assistants IA, il n’y a jamais eu de meilleur moment pour développer des solutions basées sur l’IA.

Plusieurs cas d’usage ont d’ailleurs été présentés au fil des différents talks sur les deux journées de la conférence.

Les modèles spécialisés et l’Edge Computing ont la part belle

Un point marquant de la conférence a été l’accent mis sur la sobriété énergétique dans l’usage des modèles d’intelligence artificielle.

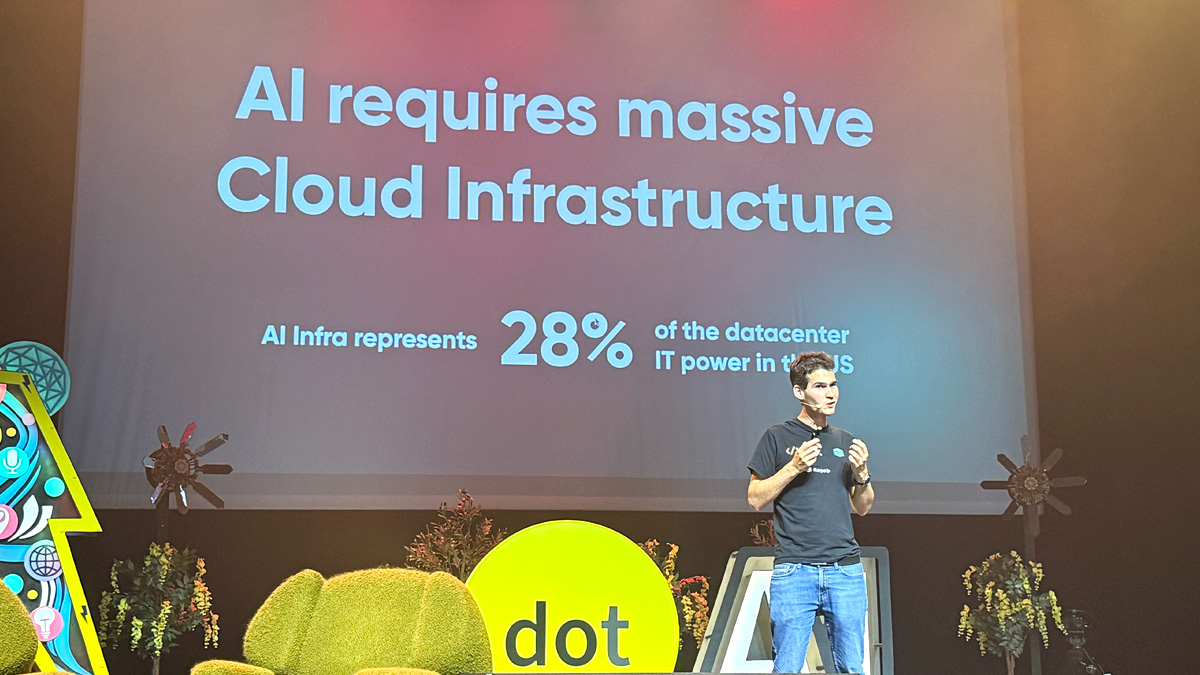

Aujourd’hui, l’IA représente environ 28% de la consommation énergétique des datacenters aux États-Unis, une consommation qui devrait augmenter de 500% dans les quatre prochaines années (chiffres rappelés par Yann Léger, l’un des co-créateurs de Scaleway). En témoignent les récentes annonces de Google, Amazon, Microsoft et OpenAI, qui tablent sur un passage au nucléaire pour alimenter leurs datacenters dédiés à l’IA.

Dans ce contexte, il devient essentiel de choisir judicieusement ses outils. Comme l’a expliqué Merve Noyan de Hugging Face, la plateforme open source de référence en IA, les plus grands modèles ne sont d’ailleurs pas toujours les mieux adaptés aux besoins spécifiques.

Les développeurs en quête de solutions plus optimisées se tournent de plus en plus vers des modèles plus compacts et spécialisés, ainsi que vers le concept d’edge computing. Celui-ci permet de traiter les données en local sur les appareils (ordinateurs, smartphones), réduisant ainsi la latence et la consommation de bande passante.

🚨 Réservez votre place pour dotAI 2025

Pierre Stock, premier employé de Mistral AI, a ainsi profité de son passage à dotAI 2024 pour présenter les derniers SLM (small language models) de la licorne française, Ministral 3B et Ministral 8B.

Contrairement aux LLM, ces modèles open source — qui comptent respectivement 3 milliards et 8 milliards de paramètres — sont parfaitement adaptés à un fonctionnement en edge computing, combinant efficacité et performance tout en réduisant les besoins en puissance de calcul et en ressources.

L’open source moteur de l’IA

C’est indéniable, l’open source s’impose progressivement comme levier majeur dans le domaine de l’intelligence artificielle, et contribue à accélérer son développement tout comme sa démocratisation.

L’initiative de Google DeepMind, représenté par son directeur de recherche Armand Joulin à dotAI, avec la sortie de son modèle open source Gemma 2 en est un exemple significatif.

En rendant ces technologies accessibles, l’objectif est de faire grandir l’écosystème de manière ouverte en donnant aux développeurs les clés pour innover.

Là où l’intégration de LLM demandait il y a encore quelques années des efforts considérables, les devs disposent désormais d’outils facilitant l’intégration de modèles directement dans leurs applications.

Une évolution qui permet au plus grand nombre, petites structures comme grands acteurs, de jouer sa part dans l’avancée de l’IA et d’en exploiter les possibilités, créant un écosystème plus inclusif et dynamique.

Les modèles évoluent vers le multimodal et le temps réel

L’IA vit actuellement une transformation majeure avec l’émergence de modèles multimodaux et l’avancée vers des capacités de réponse en temps réel.

Là où les premiers modèles portaient exclusivement sur un fonctionnement textuel, les nouvelles générations sont désormais en mesure de gérer plusieurs types de données — texte, voix, image et vidéo —, ouvrant les portes à une infinité de cas d’usage.

OpenAI, qui ouvre prochainement des bureaux à Paris, a fait sensation pendant la conférence avec une démo bluffante de sa Realtime API. Celle-ci permet aux développeurs d’intégrer des interactions vocales immédiates et fluides au coeur de leurs applications.

S’ensuit une démo de Katia Gil Guzman @kagigz de la nouvelle API en temps réel introduite par OpenAI en début de mois 🔥 #dotAI2024 https://t.co/Y8taMIq8tZ pic.twitter.com/XtfZmiBaOI

— Les Joies du Code (@lesjoiesducode) October 17, 2024

Le modèle Moshi de Kyutai, un laboratoire de recherche soutenu par Xavier Niel, est un autre exemple marquant de cette évolution.

Présenté à dotAI, Moshi est capable de gérer des interactions vocales en temps réel avec une fluidité impressionnante, et a d’autant plus été conçu pour fonctionner localement. L’une des démos présentait un cas d’usage prometteur pour les jeux vidéo en temps réel, comme les MMORPG, où les interactions rapides et naturelles sont cruciales. Vous pouvez vous-même tester Moshi ici.

On retiendra également la présentation de Doctolib et de leur nouvel assistant de consultation, capable de générer automatiquement une synthèse de consultation pour les soignants en se basant sur l’audio d’une consultation.

Les IA multi-agents : la collaboration entre intelligences

L’émergence des systèmes multi-agents marque également une avancée importante dans le domaine. Dans ces systèmes, plusieurs IA travaillent de concert, interagissant non seulement entre elles mais aussi avec d’autres applications pour accomplir des tâches complexes en toute autonomie.

💡 Prenez part à la conférence dotAI le 6 novembre 2025

Ces IA collaboratives permettent d’automatiser des workflows entiers en répartissant les tâches entre différents agents spécialisés.

À titre d’illustration, le développeur Grigorij Dudnik a présenté son projet Clean Coder, conçu pour faciliter la gestion et le développement de projets logiciels. Plusieurs agents sont ainsi capables de planifier, gérer, coder et tester des projets entiers ou de poursuivre le développement de projets déjà existants.

Mon retour d’expérience

En dehors du cadre grandiose dans lequel a eu lieu dotAI 2024 — le théâtre des Folies Bergères à Paris —, un des aspects que j’ai particulièrement appréciés est le rythme et le format des talks, construits, à la manière des TED Talks.

Chacun ne dépassait pas 20 minutes, suivi d’une petite session de questions/réponses, certains étant même condensés en 10 minutes.

Cela ne vous aura pas échappé, les intervenants étaient de grande qualité, tous experts reconnus dans le domaine, et l’agenda de ces deux jours a été pensé pour favoriser les interactions avec la communauté grâce à des pauses régulières — un espace dédié permettait même de s’entretenir avec les speakers.

J’ai d’ailleurs eu l’occasion de croiser certains d’entre vous, et ce fut comme toujours un réel plaisir d’échanger avec vous ! 😉

Save the date : dotAI a d’ores et déjà annoncé son retour le 6 novembre 2025 ! Si vous aussi vous souhaitez prendre part à cet événement incontournable de l’IA, je vous invite chaleureusement à réserver votre place dès maintenant (en présentiel ou en ligne), qui plus est au tarif “super early bird” ! 🚀