Bip bap boop — Je ne devrais pas vous apprendre grand-chose si je vous dis que la récente sortie du modèle chinois DeepSeek R1 a provoqué une turbulence monstre dans le domaine de l'intelligence artificielle, allant jusqu'à faire trembler des mastodons déjà bien établis comme Nvidia, OpenAI ou encore Meta.

Au sein du groupe tenu par le Zuck, des cellules de crise auraient même été mises en place afin de comprendre comment un modèle si peu cher est parvenu à atteindre de telles performances.

DeepSeek R1, qui se veut beaucoup moins gourmand en ressources que les modèles d'OpenAI (la startup chinoise utiliserait pour son modèle à peine 1% de l'équivalent des ressources d'OpenAI), se révèle en effet plus performant que le dernier modèle en date de la méga-startup IA américaine (c'est dire la branlée monumentale, si vous me permettez l'expression).

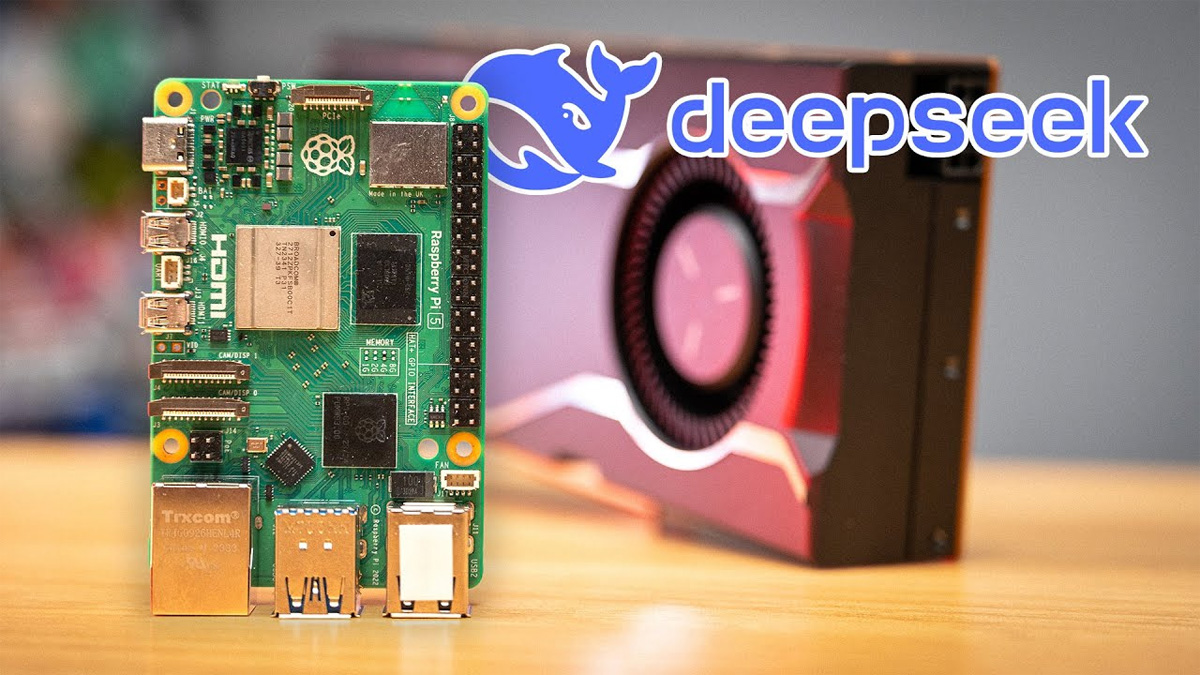

DeepSeek R1 sur un Raspberry Pi

La perspective de faire tourner un modèle d'IA sur du matériel abordable n'a pas manqué d'attirer l'attention de la communauté des développeurs Raspberry Pi, adepte des défis techniques en tout genre, et qui s'efforce depuis quelque temps de faire fonctionner ce type de modèle sur le micro-ordinateur le plus simple et le plus accessible au monde.

Comme démontré par le développeur Jeff Geerling dans sa dernière vidéo YouTube, le modèle partagé publiquement par DeepSeek est en effet techniquement capable de tourner sur un Raspberry Pi 5.

Néanmoins, permettez-moi de calmer tout de suite vos ardeurs : ne vous attendez pas à bénéficier des meilleures performances mondialement clamées pour un modèle tournant sur cette adorable bécane. 😉

Pour faire fonctionner son projet, Jeff Geerling a en effet dû remonter dans l'historique des versions de DeepSeek pour déployer la version 14b du modèle sur son micro-ordinateur — la version actuellement mise en avant par DeepSeek est la 671b (celle qui terrasserait ChatGPT), qui pèse pas moins de 400 Go.

Même en tenant compte de cette version allégée du modèle, son Raspberry Pi est parvenu à générer 1,2 token par seconde. Autrement dit, quand une question lui est posée, il faut compter environ une seconde pour afficher chaque mot. Après, si vous êtes du genre vraiment pressé, ça peut toujours le faire, hein. 👀

Comme l'indique Jeff Geerling dans l'article dédié à ce projet sur son blog, il est toutefois possible d'améliorer sensiblement les performances en y intégrant une carte graphique externe, les GPU et la VRAM qui lui sont associées étant bien plus rapides que les CPU et la mémoire système.

À l'aide d'une carte AMD W7700 (bon OK, il y va un peu plus fort sur le budget là 😅), le développeur a ainsi réussi à atteindre une vitesse moyenne comprise entre 24 et 54 tokens par seconde.

Ce qui reste beau en soi, c'est la perf du projet dans son ensemble. Jusque-là, quand il était question d'embarquer une IA sur un Raspberry Pi, on était plutôt habitué à se contenter de requêtes adressées à un serveur distant plutôt que de faire tourner le modèle directement sur le micro-ordinateur lui-même !

Vous pourrez en savoir plus en visionnant la vidéo de Jeff Geerling ici :

(Image d'illustration : Jeff Geerling sur YouTube)